"Cours, Forest, Cours": IA générative et la surproductivité

Après le succès du techno-putsch d’OpenAI sur l’IA générative, dont le fer de lance a été le lancement de ChatGPT, suivi d’une myriade de LLM par des concurrents leaders, suivi d’une avalanche de modèles, de plugins, d’applications, d’API, le monde prompteur (des affaires) s’est vu enfin promettre le Graal de la productivité.

Quelle perspective fantastique, si ce n’est pour cette question agaçante posée déjà en 1997 par le prix Nobel d’économie Paul Krugman: “Le capitalisme est-il trop productif“?

Pour expliquer son idée Krugman a développé une doctrine économique radicale hétérodoxe appelée “la surabondance mondiale”. Le terme “surabondance” fait référence à la surproduction, à l’offre excédentaire, à l’excès de l’offre.

Après de multiples tentatives pour corriger les manquements et les déraillements récurrents ainsi que les interdictions temporaires d’une technologie immature, non robuste, en violation avec les règlements des données privées et la propriété intellectuelle, les magiciens de la Silicon Valley ont finalement tiré le “lapin de la productivité” du chapeau de l’IA générative. Capitalisant abondamment sur la devise de Krugman de 1994

“La productivité n’est pas tout, mais à long terme, elle est presque tout.”

Et de retourner la médaille de la productivité pour découvrir la “surabondance de la productivité” et finalement la revanche de cette surabondance de la productivité telle mentionnée par Krugman dans un article d’opinion du NY Times en 2009.

Dans le présent article, nous analyserons le concept économique de la surabondance de la productivité de Krugman d’un point de vue technologique appliqué à l’IA générative.

Inévitablement, des questions fondamentales surgissent sur l’offre excédentaire d’outils d’IA générative, d’une part, et sur la surabondance de contenu et de données produite par ces mêmes outils, d’autre part.

Que signifie alors la productivité à l’ère de l’IA générative ? L’IA générative nous rend-elle vraiement plus productifs ? Quand est-ce que la productivité de l’IA générative devient-elle contre-productive ? Quelle est la nature de la revanche de cette surabondance technologique ?

Enfin, la productivité liée l’IA générative peut-elle être éthique ?

I. La productivité de l'IA générative

Nul besoin d’être un économiste chevronné pour comprendre la dynamique de base du marché. Il offre et demande. Les profits et déficits résultent des différences entre ces deux forces.

La productivité quant à elle est définie comme le rapport entre ce qui est produit et ce qui est nécessaire pour produire. La relation entre la ressource et le résultat d’une production, principalement en ce qui concerne la productivité du travail. Un travailleur produisant un résultat.

Récemment, la rhétorique de la productivité liée à l’IA générative a été répandu à tout va. En poussant ardemment le bouton d’urgence FOMO (Fear of Missing out – Peur de rater) des entreprises et des utilisateurs : des propos comme “si vous n’adoptez pas l’IA générative, votre entreprise ira dans le mur” ; de même pour les particuliers : “si vous n’utilisez pas ces outils de productivité, vous ne serez pas aussi performant et utile que ceux qui les utilisent”.

La rhétorique de la productivité

La rhétorqiue de la productivité autour des nouveaux outils bat son plein. Une recherche rapide sur Google produit une liste impressionnante de contenu lié à la maximisation de la productivité au travers de l’IA générative.

Le matraquage marketing est complété par des déclarations officielles d’institutions internationales comme la Banque mondiale, en écoutant Jan Walliser, vice-président du groupe de pratique Croissance équitable, finance et institutions (EFI). Il insiste fort sur “l’accélération de la croissance” quand il affirme que ‘”apporter les conseils les plus récents à nos clients sur l’accélération de la croissance” est une priorité absolue.

Quelques exemples trouvé sur Internet et dans les médias sociaux montrent à quel point la machine rhétorique de la productivité est roulée et efficace.

Jouer sur la confusion sémantique et la compréhension ambiguë du concept de “productivité”

Les prévisions de productivité par les outils de l’IA générative sont elles avérées?

Deux observations s’imposent : premièrement, il n’y a jusqu’à présent aucun signe de gains de productivité globale grâce à l’IA générative; deuxièmement, une confusion conceptuelle (accidentelle ou intentionnelle) liée à la “productivité” sert le récit miraculeux. Déjà que le concepts de base ne sont jamais universellement compris, mais sont sujette à l’interprétation individuelle, comme le montre l’exemple du concept d base pingouin, les écarts sont d’autant plus importants pour des concepts techniques élaborés.

Dans le cadre de l’IA générative, les leadders de la tech se servent de l’ambiguité du concept productivité. Lorsqu’ils parlent de la productivité de l’IA générative, ils parlent d’outils basés sur la performance ; cependant, les entreprises et le grand public extrapolent et comprennent le boom de la productivité globale.

La productivité de l’IA générative, pour l’instant, n’est liée qu’aux tâches, donc aux performances. Cette confusion est habilement transformée en récit “hallucinant de productivité”.

“Ralentissement prolongé” de la productivité

Erik Brynjolfsson, professeur à Stanford invité chez Microsoft utilise les mêmes hyperboles dans sa rhétorique du “Comment l’IA va transformer la productivité”.

“Je pense que ces outils peuvent conduire à une prospérité plus largement partagée, et je l’espère. Si nous jouons bien nos cartes, la prochaine décennie pourrait être l’une des meilleures de l’histoire de l’humanité.” Affirmation exagérée et prophétique rapidement neutralisé par le factuel Krugman.

“Les prévisions sur l’impact économique en matière de technologie sont notoirement peu fiables. P. Krugman

Selon le Prix Nobel en économie, l’essor des grands modèles de langage (LLM) tels que ChatGPT et Bard de Google ne devrait, pour l’instant, pas avoir d’impact économique majeur .

“L’histoire suggère que les effets économiques importants de l’IA prendront plus de temps à se matérialiser que ce que de nombreuses personnes semblent attendre actuellement. Cela ne veut pas dire que l’intelligence artificielle n’aura pas d’énormes répercussions économiques”, conclut-il. “Mais l’histoire suggère qu’ils ne se produiront pas rapidement et qu’il y aura un ralentissement prolongé de la productivité.

“ChatGPT et tout ce qui s’ensuivra sont probablement une histoire économique pour les années 2030, et non pour les prochaines années.

Pour illustrer son propos, Krugman se réfère au déploiement de l’informatique au milieu des années 1990 et son effet nettement décalé sur la productivité du travail.

II. La productivité de la surabondance

L’autre facette radicalement radiée du discours de la productivité est ce que Krugman appelle “la surabondance” liée à cette même productivité.

L’IA générative comme phénomène mondial s’est généralisé du jour au lendemain, à grande vitesse et à grande échelle. Trop tôt, trop vite et partout. En excès.

Les gens produisent et fournissent plus de contenu que nécessaire voire demandé. D’où la surabondance liée à la productivité constatée matériellement.

Krugman définit la surabondance comme effet d’un capitalisme trop productif pour son propre bien.

“Grâce aux progrès technologiques rapides et à l’extension de l’industrialisation aux nouvelles économies émergentes, la capacité à travailler s’est développée plus rapidement que la quantité de travail à effectuer.

Qu’est-ce la surabondance ?

Le dictionnaire Merriam-Webster définit la surabondance comme une offre excédentaire ou quantité excessive. L’offre dépasse la demande. Un débordement, une inondation, un excès de production.

L’idée d’une productivité excessive n’est pourtant pas nouvelle. Comme le souligne Krugman, déjà l’après-guerre a été marquée par l'”automatisation”, le remplacement des hommes par des machines. La surabondance mondiale est toutefois restée en sommeil entre les années 1950 et 1980, ce qui coïncide ironiquement avec ce que l’on appelle l’hiver de l’intelligence artificielle.

La doctrine de la surabondance mondiale dévelopée par l’économiste Américain repose sur trois propositions

(1) La capacité de production mondiale augmente à un rythme exceptionnel, voire sans précédent.

(2) La demande dans les pays avancés ne peut suivre la croissance de l’offre potentielle.

(3) La croissance des nouvelles économies émergentes contribuera beaucoup plus à l’offre mondiale qu’à la demande mondiale.

Ces trois propositions peuvent également s’appliquer à la surabondance de productivité créée par les outils de l’IA générative.

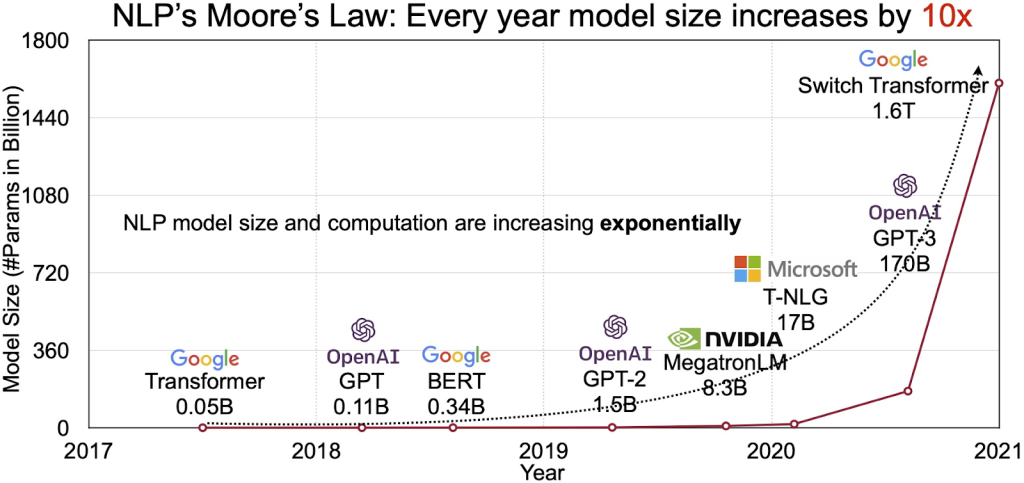

Dans le contexte des grands modèles de langage, la notion de volume excédentaire et surdimensionné fait partie intégrante de la dénomination “grand modèle de langage”. La quantité de données nécessaires pour faire fonctionner ces modèles transformateurs est énorme et les modèles se succèdent à pas de géants, même si Sam Altman a récemmment affirmé que l’ère des LLM géants était révolue.

De la productivité à la surproductivité de l’IA génératrive

Dans le cas de l’IA générative, ne sommes-nous pas confrontés à une surabondance de productivité plutôt qu’à la productivité elle-même ? La surabondance étant la revanche de la productivité à but général, sans but.

En avril 2023, plus de 1 000 outils d’IA générative ont été lancé. Accompagnés d’une rhétorique euphorisante comme “Les 100 meilleurs outils d’IA pour stimuler votre productivité” ou “l’IA générative telle que ChatGPT et Midjourney pour améliorer les ventes, le marketing et la productivité opérationnelle” ou “il est impératif que les organisations tirent parti de cette technologie pour rester à la hauteur des exigences et de la productivité du monde moderne”.

Dans l’espace d’un mois, tellement de LLM ont été lancés qu’il devient très difficile de suivre le rythme. En plus de GPT, voilà Llama, Alpaca (Stanford), Vicuna (Université de Californie/Mellon/Stanford/Berkley, San Diego), Koala – peaufiné sur LLaMA (Berkley Research Institute), Nebuly (open-source d’IchatLLama), Freedom GPT (open-source sur Alpaca), ColossalChat – type ChatGPT basé sur Llama (Berkley), Dolly (Databricks), pour n’en citer que quelques-uns.

Parallèlement, suite aux licenciements massifs par les Meta, Google, Twitter et autres, la concurrence et la création incalculables de modèles plus rapides et moins coûteux ont vu le jour.

Quel est l’objectif de la productivité ?

“L’amélioration de la productivité est essentielle pour créer des entreprises durables et des emplois décents, deux éléments fondamentaux de toute stratégie de développement dont l’objectif principal est d’améliorer la vie des gens”, tiré de la préface de “Driving Up Productivity”, publié par l’Organisation internationale du travail en 2020.

Selon une enquête réalisée en mars 2023 par wordfinder.yourdictionary.com auprès de 1 024 Américains et 103 experts en IA, 41 % des personnes interrogées admettent utiliser le site d’IA pour générer des idées, 11 % pour générer du code informatique, 10 % pour rédiger des CV et des lettres de motivation, et 9 % pour créer des présentations.

Ce sont des chiffres assez faibles pour une productivité nationale dans des domaines très spécifiques.

“Il ne suffit pas d’avoir une technologie. Il faut aussi savoir ce qu’on en fait”. Krugman

Traditionnellement, l’objectif de la productivité a été la prospérité, la croissance, la performance, la compétitivité, la génération de revenus, le profit, le bénéfice, la capitalisation du marché, à un niveau macro-économique. Au niveau en-dessous, en gestion d’entreprise, on trouve des concepts tels que l’excellence, la qualité, l’efficacité, l’efficience, …

Mais la surabondance n’a pas d’objectif, et la productivité de la genAI a vivement besoin de ce que les anglo-saxons appellent “purpose”.

Les objectifs utilitares et éthiquement vides qui nous ont été servis par des styles de leadership sans scrupules, des stratégies irresponsables et des promesses peu fiables autour du “bien commun” nous ont fortement bousculés. D’où la nécessité de redéfinir les objectifs liés à l’IA générative.

III. La revanche de la suproductivité de l'IA génératrive

La surabondance est vengeresse. L’impact économique de la surabondance mondiale évoqué par Krugman a été qualifié de “revanche de la surabondance“.

“Si vous voulez savoir d’où vient la crise mondiale, pensez-y de la manière suivante : nous assistons à la revanche de la surabondance.”

L’introduction d’une technologie améliorée pourrait avoir des effets négatifs selon Krugman. Cette affirmation peut facilement être observée dans le contexte de l’IA générative. Le dernier a avoir quitté la Big Tech est le pionnier de l’IA Geoffrey Hinton quittant Google pour mettre la société en garde contre les risques de l’IA.

Quand la productivité devient-elle contre-productive ?

Nous pouvons envisager trois scénarios : trois niveaux de dettes; dette intellectuelle, écologique et éthique.

La dette intellectuelle

Le concept de “dette intellectuelle” a été introduit pour la première fois par Jonathan Zittrain dans l’article du New Yorker intitulé “The Hidden Costs of Automated Thinking” (Les coûts cachés de la pensée automatisée) en 2019.

Zittrain affirme qu’une dépendance excessive à l’IA peut mettre la société en dette intellectuelle. “Alors que nous commençons à intégrer leurs connaissances dans nos vies, nous commencerons, collectivement, à accumuler de plus en plus de dettes intellectuelles.”

“Un monde de connaissances sans compréhension devient un monde sans cause et effet discernables, dans lequel nous devenons dépendants de nos concierges numériques pour nous dire quoi faire et quand.”

Dette écologique

Il n’est pas nouveau d’entendre que la technologie consomme énormément d’énergie. Cela a commencé avec la Big Data, le cloud computing et les centres de données. En 2011, Greenpeace a publié un rapport largement salué intitulé “How dirty is your data ? – A Look at the Energy Choices That Power Cloud Computing”, qui mettait l’accent sur l’empreinte carbone et énergétique des technologies de l’information.

Ce rapport a été suivi par d’autres rapports de Greenpeace comme “Clicking Green” et le dernier rapport annuel “Clean Cloud 2022 on ChinaTech“.

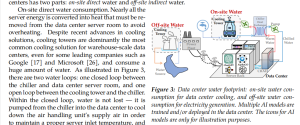

Or les LLM jouent dans une toute autre catégorie. Des chercheurs de l’université de Californie Riverside et de l’université du Texas Arlington ont récemment partagé un article qui n’a pas encore été examiné par les pairs, intitulé “Making AI Less Thirsty” (Rendre l’IA moins assoiffée).

Les conclusions sont choquantes.

L’article révèle comment l’impact environnemental de “l’entraînement de GPT-3 dans les centres de données américains de pointe de Microsoft peut consommer 700 000 litres d’eau douce propre (assez pour produire 370 voitures BMW ou 320 véhicules électriques Tesla)”.

“ChatGPT doit “boire” une bouteille d’eau de 500 ml pour une simple conversation d’environ 20 à 50 questions et réponses.

Multplions ce chiffre par des milliards d’utilisateurs de ChatGPT.

“LaMDA de Google peut consommer une quantité impressionnante d’eau, de l’ordre de plusieurs millions de litres, et GPT-4, récemment lancé, a encore une taille de modèle beaucoup plus importante.

Dette éthique

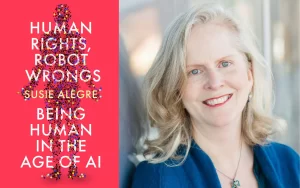

Le concept de “dette éthique” lié à la technologie générative de l’IA a été introduit par Casey Fiesler. L’éthicienne de l’IA insiste à juste titre sur la responsabilité des grands de la Tech, les GAFAMOpenAI et autres, en ce qui concerne les dommages sociétaux qui surviendront plus tard.

Dans l’article intitulé “AI has social consequences, but who pays the price” (L’IA a des conséquences sociales, mais qui en paie le prix ?), l’auteure explique la “dette éthique” comme une forme dérivée de la “dette technique”.

“Dans le développement de logiciels, le terme “dette technique” fait référence au coût implicite des corrections futures résultant du choix de solutions plus rapides et moins prudentes aujourd’hui. (Fiesler)

Se référant aux préoccupations éthiques et juridiques bien connues des systèmes d’IA qui amplifient “les préjugés et les stéréotypes nuisibles, les préoccupations en matière de protection de la vie privée, les personnes trompées par la désinformation, l’exploitation de la main-d’œuvre et les craintes concernant la rapidité avec laquelle les emplois humains peuvent être remplacés”.

Tout comme la dette technique peut résulter de tests limités au cours du processus de développement, la dette éthique résulte de l’absence de prise en compte d’éventuelles conséquences négatives ou de préjudices sociétaux. Et dans le cas de la dette éthique en particulier, les personnes qui la contractent sont rarement celles qui la paient en fin de compte. (Fiesler)

Nous aimerions aller encore plus loin. Au lieu de lier uniquement la dette éthique aux leaders de la technologie comme originaires, nous pensons que nous tous, utilisateurs, portent également une responsabilité envers la société. En tant que membres de la société, nous sommes tous équi-responsables de nos choix et de nos actions.

À nous d’être clairs à ce sujet. Les dettes intellectuelles, écologiques et éthiques ne sont pas uniquement le fait des grandes entreprises technologiques. C’est notre choix à tous d’utiliser ou non les outils technologiques à l’excès, et d’en définir notre but, en connaissance de cause des effets sur les êtres humains et la nature.

Le cercle vertueux des dettes humaines

La combinaison des trois dimensions de la dette globale causée par la surabondance de productivité de l’IA générative et de l’IA peut être vu comme des cercles vertueux.

IV. À quoi ressemble la surproductivité de l'IA génératrive?

Après seulement plusieurs mois, nous observons déjà les résultats de la surabondance de la productivité de l’IA générative et en subissons les conséquences.

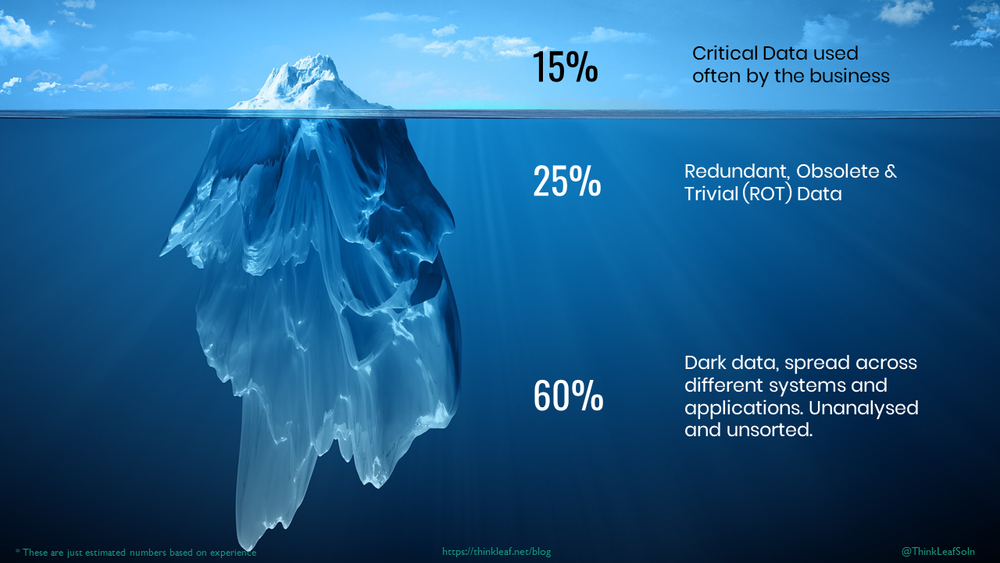

La surabondance de la Dark Data

La quantité astronomique de données produites quotidiennement, au niveau de l’entreprise et de l’individu, concentre une grande part de données qui ne sont jamais lues, ni écoutées ou vues; ce sont des données perdues. Ces données ne sont jamais analysées, ne sont ni triées ni utilisées et restent en suspens dans les serveurs.

Inutiles mais produites, elles encombrent l’espace et utilisent des ressources. La dark data.

Ces données devraient considérablement augmenter avec les technologies génératives. Elles pourraient bientôt représenter la majorité de nos données produites, car les modules génératifs intégrés en IoT ou IoMT produisent principalement des données non structurées, qui sont les plus difficiles à trier.

“D’ici 2025, IDC estime qu’il y aura 175 zettaoctets de données dans le monde (175 avec 21 zéros), dont 80 % de données non structurées.

- 90 % des données non structurées ne sont jamais analysées”.

Encore plus de bouteilles d’eau pour stocker ces données. Cette surabondance de données a un impact massif sur la nature et augmente l’empreinte écologique de manière colossale. Les données vertes n’ont pas leur place dans les technologies génératives.

Surabondance de données décisionnelles: s’abandonner à l’automatisation

La surabondance de données produit aussi un effet psychologique sur les entreprises, et principalement sur les décideurs. L’excès de données disponibles s’avère contre-productif dans le processus de la prise de décision.

Le dernier rapport The Decision Dilemma d’Oracle traite une question cruciale: Les données aident-elles ou nuisent-elles ?

- 72 % des personnes interrogées admettent que le volume de données ainsi que leur propre manque de confiance dans les données les ont empêchées de prendre une décision.

La surabondance de données a un effet psychologique contre-productif sur les cadres, les employés et les utilisateurs: ils se sentent dépassés.

Étude: les données nuisent à la qualité de vie et aux performances des entreprises.

En plus de se sentir dépassés, les gens ne se sentent pas suffisamment qualifiés pour utiliser les données afin de prendre des décisions.

La conséquence est que “les cadres dépassés sont les plus susceptibles de confier les décisions aux systèmes”.

S’en suivent une détresse décisionnelle et un “étouffement” de la réussite.

La détresse décisionnelle

- 85 % des chefs d’entreprise ont souffert d’une détresse décisionnelle.

- 83 % des personnes reconnaissent que l’accès à davantage de données devrait faciliter la prise de décision, mais

- 86 % déclarent que même avec plus de données, ils se sentent moins sûrs d’eux pour prendre des décisions.

L’étouffement de la réussite

- 91 % des chefs d’entreprise admettent que le volume croissant de données a limité le succès de leur organisation.

Dans un avenir très proche, la plupart des informations sur Internet seront au mieux moyennes, voire mauvaises, un mix de désinformation, fake news, deepfakes, opinions polarisées.

Avec l’hyperproduction de données synthétiques, les données non traitées par l’IA générative seront vite difficiles à trouver. Les bonnes idées, les styles originaux et les idées recherchées devront se battre contre les textes moyens, copiés et collés.

Des clients fortunés à la recherche d’un service plus performant

Une conséquence potentiellement prévisible pourrait être qu’un certain profil de personnes n’utilisera plus certaines technologies et que certains clients préféreront que les entreprises qui travaillent différemment.

Les clients fidèles et surtout les plus aisés préféreront des standards plus élevés que la moyenne des produits générés par des intelligences artificielles.

Les bons clients n’accepteront pas d’être spammés par des messages auto-générés et rechercheront un service plus sophistiqué, plus humain. L’humain devendra l’exception… ironie du sort.

Surabondance dans le pipeline de production

La génération excessive de contenu et la prolifération des données peuvent accélérer les processus, mais seulement jusqu’à un certain point et à une certaine partie de la chaîne globale de production. La GenAI n’est pas un facilitateur de processus, mais un facilitateur d’une partie du processus car lié à des tâches spécifiques..

La génération excessive de contenu et la prolifération des données peuvent accélérer certaines parties d’un processus, mais à un certain moment, elles ralentissent la chaîne de production globale.

L’IA générative ne s’occupe que d’une seule tâche à un moment T. Dans une telle constellation, la congestion causée par la surabondance est extrêmement dangereuse.

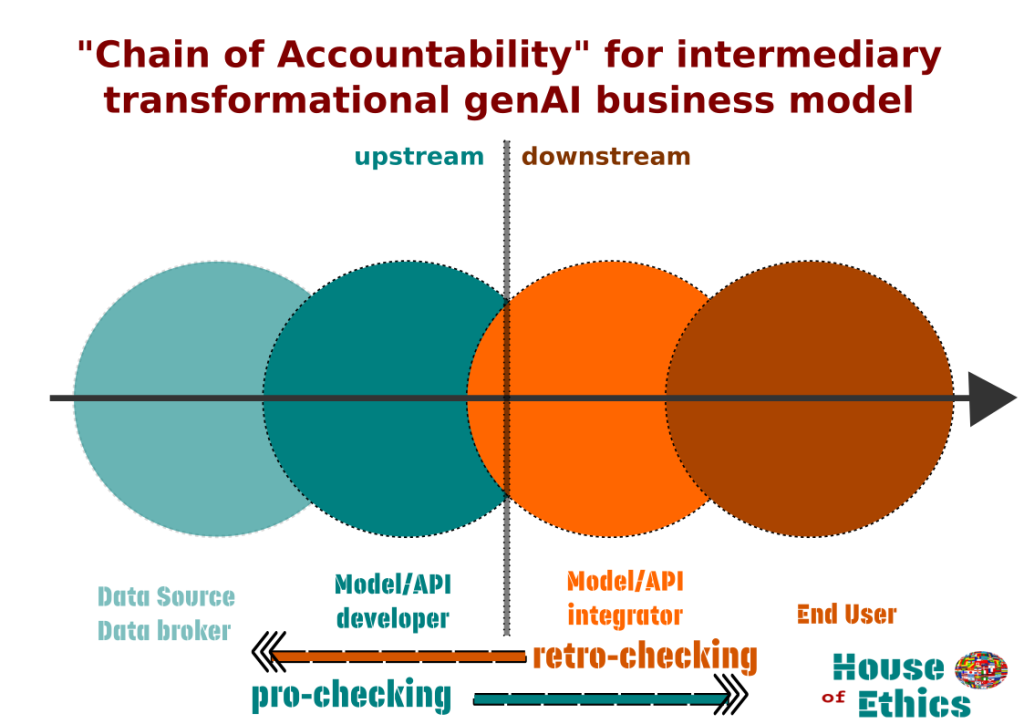

Dans un article coécrit avec Daniele Proverbio sur l’IA générative et la Responsabilité, la gestion de la chaîne de responsabilité est identique à la gestion de la surabondance de productivité.

La surabondance subit le même effet d’entraînement que la responsabilité dans un processus de flux de données.

La production de surabondance ne se produit jamais simultanémen sur l’ensemble de la pipeline. Elle est localisée car liée à des tâches spécifiques. Cependant, elle affecte l’ensemble du pipeline.

Une congestion locale affecte l’ensemble du processus et se répercutera sur l’ensemble des coûts-bénéfices à grande échelle.

Un exemple de surabondance de productivité accélérant d’abord et ralentissant ensuite le processus a été observé dans les laboratoires de biosynthèse, comme ldécrit dans l’article “Does automation do more harm than good” (L’automatisation fait-elle plus de mal que de bien) d’Adi Gaskell.

“La promesse est que l’IA permettra aux scientifiques d’augmenter massivement leur travail tout en leur faisant gagner du temps qu’ils pourront consacrer à d’autres tâches.

Or la réalité n’est pas aussi tranchée”.

À ceci s’ajoutent des problèmes éthiques et juridiques de la responsabilité en cas de soucis. La rapidité initiale pourrait se traduire par un manque à gagner financier et un retard de production globale.

Escroqueries, risques pour la vie privée et la confidentialité

Avec la productivité 24/7 de l’IA générative, un autre type de surabondance de la productivité va augmenter exponentiellement: les escroqueries.

Le tsunami d’escroqueries et de cybersécurité pour les entreprises est largement passé sous silence et sous-évalué dans le matraquage sur la productivité.

Il va sans dire que les LLM ou LlaMA seront rapidement exécutés et à peu de frais sur les ordinateurs portables des escrocs et “peuvent désormais exécuter des centaines ou des milliers d’escroqueries en parallèle, nuit et jour, avec des marques dans le monde entier, dans toutes les langues”, comme le décrit l’article “Brace Yourself for a Tidal Wave of ChatGPT Email Scams” (Préparez-vous à un raz-de-marée d’escroqueries par courrier électronique par ChatGPT).

La confidentialité est un autre écueil souvent négligé de l’engouement pour la productivité. JPMorgan Chase a restreint l’utilisation de ChatGPT par ses employés pour des raisons de conformité et de respect de la vie privée qui touchent à son cœur de métier. PWC par contre, a annoncé le déploiement d’un service de chatbot pour 4 000 de ses avocats dans plus de 100 pays afin de gagner du terrain; PWC prévoit d’étendre le chatbot à son service fiscal.

Le cabinet d’avocats Allen & Overy était un des premiers à s’être “associé à une startup soutenue par Open AI, créateur de ChatGPT, pour lancer un chatbot destiné à aider ses avocats dans diverses tâches juridiques”. En insistant simultanément sur le fait que leurs honoraires ne seraient pas réduits pour les clients. ( !!!)

Le cabinet Magic Circle Allen & Overy a déployé l’outil – nommé Harvey et décrit comme un “changeur de jeu “offrant une efficacité et une intelligence sans précédent” (… !!! …).

Considérez ceci: si les données que vous collez, écrivez dans ChatGPT ou dans n’importe quel LLM sont utilisées pour former davantage ces outils d’IA, alors vous servez ipso facto vos données à quelqu’un d’autre. Peut-être votre concurrent. Et si ce quelqu’un d’autre est l’ingénieur super compétent de votre concurrent capable d’extorquer des informations de la boîte, vos informations, eh bien…

En particulier pour la facilité tant vantée et revendiquée de rédiger des rapports de réunion, de réviser des contrats, de composer des courriels d’entreprise ou toute autre tâche organisationnelle qui prend du temps.

Nous entrons dans une nouvelle ère d'”espionnage industriel” à grande échelle et à faible coût.

La déclaration d’OpenAI sur la sécurité de l’IA (similaire à celle de Bard de Google et d’autres dévelopeurs de LLM sur la sécurité de l’IA) pourrait être lue très différemment aujourd’hui.

“Nous n’utilisons pas les données pour vendre nos services, faire de la publicité ou établir des profils de personnes – nous utilisons les données pour rendre nos modèles plus utiles pour les gens.”

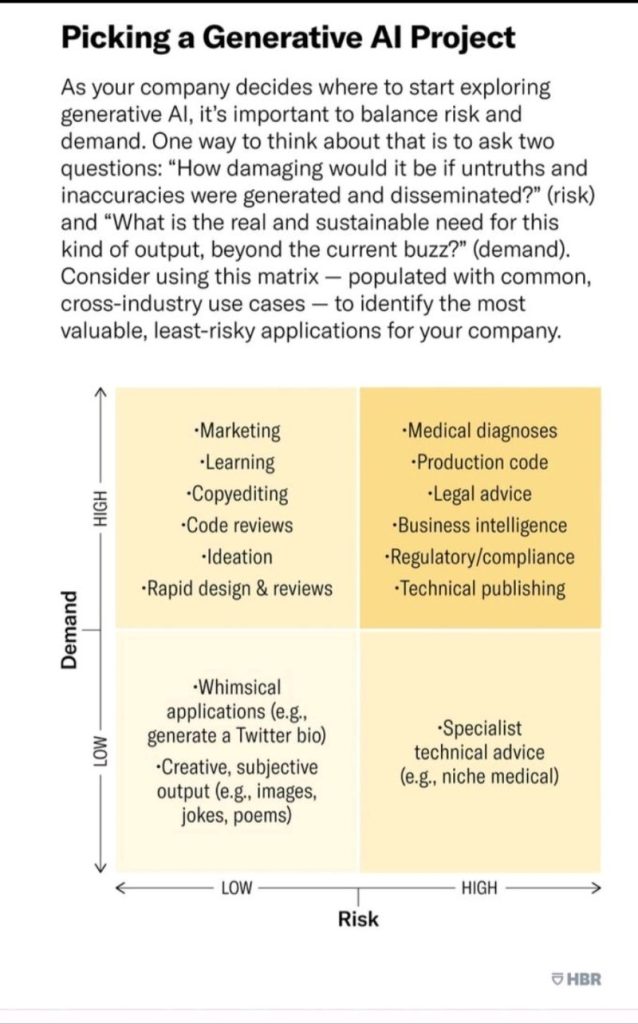

La matrice suivante, établie par la HBR, donne des indications sur les demandes et les risques faibles et élevés liés à l’utilisation des outils GenAI. Vous remarquerez que la plupart des tâches de niveau moyen mais communes sont très deamndées et peu risquées. Toutes les tâches nécessitant une réflexion critique, une expertise plus poussée, de la confidentialité, de l’exactitude et de la véracité se situent dans le quadrant haut/élevé.

V. La productivité peut-elle être éthique? Tout dépend de l'objectif.

Et si l’adoption rapide du phénomène de l’IA générative ne témoignait pas de l’efficacité du système technologique per se, mais plutôt des lacunes et inefficacités des entreprises? Un signe que la plupart des acteurs du marché échouent à définir des objectifs durables et compétitifs?

Dans cette tâche l’IA générative ne sera d’aucun recours. La plupart des systèmes d’apprentissage automatique ne découvrent pas les mécanismes de causalité. Ce sont des moteurs de corrélation statistique. C’est à nous de nous concentrer sur le POURQUOI, l’objectif, la “purpose” et commencer à revaloriser.

À l’heure des technologies polyvalentes, la finalité devient essentielle. La génération de revenus à long terme peut être trouvée dans des domaines compensatoires à la technologie, là où la stratégie de marque a commencé. La fidélisation des employés, la fidélisation des clients, la gestion de la qualité au lieu de la gestion des risques.

Il est donc impératif de définir clairement l’objectif de l’entreprise. Calibrer et sortir du tunnel de calcul et de la productivité liée à l’IA générative seule. Les questions à poser sont les suivantes

Quelles sont les valeurs liées à la productivité ?

Quelle est la finalité humaine de la productivité ?

“Optimiser pour Quoi?” L’importance de la “purpose”.

Récemment, la Columbia University a orgnisé un symposium au titre provocateur: “Optimiser pour Quoi?” Ce retour aux sources est des plus révélateurs.

Aller en profondeur et au-delà des métriques du marché. C’est ici que la productivité éthique entre en jeu et se poser des questions telles “Notre productivité est-elle porteuse de valeur ajoutée? Crée-t-elle des opportunités et se traduit-elle par un sens pour les personnes et la société?”

Traduire les avantages éthiques en bénéfices financiers en évaluant la purpose autour de trois niveaux de productivité éthique : la productivité carbone, la productivité sociale et la productivité humaine.

Productivité carbone: durabilité et attention

Dans l’article “What if we measured the thing that matters most : “carbon productivity”“, l’Australien David Peetz note que les gens demandent de la croissance économique et la survie écologique.

L’ESG a été l’un des sujets les plus brûlants de ces dernières années. Cependant, très peu d’entreprises sont des champions. La marque de vêtements outdoor Patagonia a été radicale et rendre ses clients fiers de porter ses vêtements. Ou encore la marque finlandaise Marimekko, spécialisée dans le style de vie et l’ameublement d’intérieur. Ces deux marques ont intégré la durabilité dans leurs produits et dans leur esprit et créé de la profitibilité à long terme.

Productivité sociale: objectif et responsabilité

La productivité sociale est la réponse à la question: qu’est-ce que mon produit, ma marque ou mon service ajoute à la vie des gens? Quelle est la valeur de notre entreprise?

C’est ici que prévalent des concepts éthiques tels que la justice, l’équité, l’inclusion et le care. L’éthique du care est l’approche la plus pratique de la productivité sociale optimale.

La responsabilité partagée à l’égard de la société et le devoir de diligence sont les forces motrices de la productivité éthique.

Productivité humain: performance, confiance et responsabilisation

La construction de marques humaines fortes est la clé à la productivité humaine. Le choix d’une approche centrée sur les employés, les clients, par opposition à une approche centrée sur les performances, a été un choix stratégique qui a changé la donne pour Airbnb. L’entreprise a atteint sa toute première rentabilité annuelle de 1,9 milliard de dollars en 2022.

Si les stratégies de performance sont importantes pour stimuler la croissance du chiffre d’affaires, la construction d’une marque humaine est cruciale. Encore plus en ces temps de digitalisation et techno-transformation.

De plus en plus, l’érosion de la sécurité psychologique et l’anxiété liée à l’IA sont des freins à la performance.

La vidéo suivante explique les avantages managériaux de la confiance par rapport à la performance.

Pour de nombreux dirigeants, ce nouveau tournant de l’IA pourrait être un signal au réveil pour réévaluer la valeur de leur marque, de leur produit et de leurs employés. Et de revoir la pertinence de leurs valeurs et objectifs pour définir une feuille de route de productivité durable et éthique. Ainsi leur course aura un sens et un but.

Commentaires du Dr. Ingrid Vasiliu-Feltes et de Cary Lusinchi, FHCA

Dr. Ingrid Vasiliu-Feltes I Deep-tech Entrepreneuse

L’IA générative a un immense potentiel pour transformer l’éducation, l’apprentissage, les flux de travail et la productivité. Cependant, je n’approuve pas les positions radicales qui visent à empêcher l’adoption ou à encourager l’adoption chaotique et à grande échelle de cette technologie sans analyse des risques adéquate et la mise en place des programmes d’éthique numérique proactifs.

Il est impératif d’adopter une approche équilibrée et responsable qui donne la priorité aux principes éthiques et à une solide gouvernance des données. Bien que l’IA générative puisse améliorer la vitesse d’exécution de certaines tâches pré-entraînées et accroître notre efficacité, elle dépend fortement d’ensembles de données valides et authentifiés, qui nécessitent des instructions spécifiques pour produire les résultats attendus ainsi qu’un niveau élevé d’expertise humaine pour évaluer la véracité des résultats.

Il est également essentiel de veiller à ne pas compromettre la vie privée et ne pas amplifier les préjugés préexistants. C’est pourquoi je plaide pour un déploiement de l’IA générative responsable, transparent, imputable et digne de confiance, avec la mise en place de garde-fous éthiques numériques proactifs et rigoureux.

L’intelligence hybride augmentée, qui combine les forces humaines et celle des machines est sur le point de transformer les industries et de révolutionner notre façon d’apprendre, d’éduquer et de travailler.

Toutefois, pour exploiter pleinement le potentiel de cette technologie, il est essentiel de mettre en place une gouvernance des données solide et une surveillance stricte des flux de travail virtuels entre l’homme et l’ordinateur afin d’éviter les manquements à l’éthique et à la cybersécurité. Cela nécessite un fonctionnement cognitif exécutif optimal et une conception éthique de toutes les interactions entre l’homme et l’ordinateur. Lorsqu’elle est déployée dans le respect de l’éthique numérique et des cadres de gouvernance des données, l’intelligence hybride augmentée (HAI) peut tirer parti des forces complémentaires de l’intelligence humaine et de l’intelligence machine.

Une solide gouvernance des données est essentielle pour une utilisation éthique et efficace de l’intelligence augmentée hybride. Il s’agit notamment de garantir le consentement, l’authentification, la validation et la provenance des données. Outre la gouvernance des données, il est important d’exercer une surveillance stricte des flux de travail virtuels entre l’homme et l’ordinateur afin d’éviter les atteintes à l’éthique et à la cybersécurité.

Il faudrait également que tous les algorithmes déployés soient transparents et explicables, afin que les processus de prise de décision soient clairs et compréhensibles.

Pour garantir un fonctionnement cognitif exécutif optimal, il serait essentiel que tous les membres de l’équipe impliqués dans l’une des étapes du cycle de vie de l’IA générique aient une bonne compréhension des avantages et des risques potentiels de l’IA, ainsi qu’une connaissance approfondie des capacités et des limites de la technologie.

Il est également important d’entretenir une culture de la prise de décision éthique, avec des lignes directrices, des procédures opérationnelles, des indicateurs clés de performance et des mesures claires en matière d’éthique. La mise en œuvre d’un “modèle d’éthique dès la conception de l’interface utilisateur” à chaque niveau et à chaque étape est essentielle pour garantir que toutes les interactions entre l’homme et l’ordinateur se déroulent de manière éthique et avec le plus haut niveau d’intégrité.

Cary Lusinchi, FHCA I Fondatrice de www-aiauditor.com

L’IA générative seule ne permettra pas d’obtenir une productivité qui offre une valeur réelle et mesurable en termes de retour sur investissement. À l’heure actuelle, le travailleur moyen qui interagit avec ChatGPT-4 ne peut effectuer qu’une seule tâche à la fois. Par exemple, vous pouvez seulement poser une question et obtenir une réponse/un résultat avant qu’il n’y ait besoin d’une direction et d’une intervention humaines plus manuelles (c’est-à-dire d’un message-guide).

Nous avons tous constaté que l’IA générative a tendance à s’effondrer et à perdre en performance/précision lorsque vous lui confiez des tâches à plusieurs étapes ou une chaîne de questions complexes et interdépendantes.

L’automatisation à grande échelle permet aux entreprises de réaliser des gains de productivité mesurables. AutoGPT, une application open source récemment publiée qui exploite GPT-4, pourrait être la transformation de l’IA générative en matière d’automatisation.

AutoGPT divise les tâches multiples complexes en tâches plus petites, puis fait tourner des instances indépendantes en traitement parallèle pour travailler sur ces tâches.

Ce sont les “nouveaux chef augmentés”, des” chefs de projet puisqu’ils coordonnent et planifient les tâches de travail, les compilent et livrent le résultat.

AutoGPT peut être automatisé à 100 %, ce qui signifie qu’il est capable d’effectuer des tâches sans aucune intervention humaine ou orientation. Cependant, les agents IA récursifs autonomes (AutoGPT) ne sont puissants qu’en fonction de l’accès que vous leur donnez par le biais d’une API. Oui, nous pourrions obtenir des gains de productivité magiques grâce aux agents autonomes d’AutoGPT (les chefs de projet vont-ils disparaître ?), mais à quel prix ?

Et les coûts valent-ils vraiment les gains ?

Que se passe-t-il lorsque l’on supprime l’interaction humaine fréquente et délibérée et l’agence du flux de travail ?

Quels sont les biais d’automatisation qui s’amplifient lorsque la planification et la prise de décision autonomes se produisent à grande échelle ?

Qui est responsable de l’évaluation et du test du travail d’AutoGPT ?

Lorsque les API sont mal ou hâtivement intégrées dans AutoGPT, les vulnérabilités sont nombreuses; combien de cybercriminels auront accès à des informations confidentielles et à des données sensibles ou exécuteront d’autres actions malveillantes ?